Краулинговый Бюджет Что Это И Как Влияет На Индексацию Сайта? Оптимизация Краулингового Бюджета

Ссылки, приводящие к несуществующим страницам или документам, в результате чего может выскакивать ошибка 404, способны отпугнуть пользователей. Вместе с тем они негативно влияют на поведенческие факторы и мешают нормальной работе поисковых ботов. Рассмотрим основные и самые эффективные методы, позволяющие оптимизировать ресурс. Они положительно влияют на факторы, увеличивающие краулинговый бюджет, а также помогают настроить взаимодействие с поисковыми ботами, а, следовательно, получить большую выгоду. Возможность оптимизировать график размещения новых материалов — чем регулярнее публиковать новые тексты, новости, тем логичнее выстроится график визитов роботов ПС.

Принципы Формирования И Расчета Краулингового Бюджета

Кроме того, это приводит к расходам краулингового бюджета на переходы по таким ссылкам. Для их обнаружения можно использовать инструмент проверки URL в Search Console или другие сервисы. Теперь необходимо разделить краулинговый бюджет количество страниц в индексе на среднее число обращений — получится индекс краулингового бюджета.

Когда речь идет про сканирование и индексацию, поисковики предпочитают уделять больше внимания наиболее важным страницам сайта. Это означает, что к путь к любой страницы сайт, должен быть не более чем в трех кликах от главной страницы сайта. Для запросов поискового робота чем выше значение, тем лучше, но для двух других значений верно обратное.

- ▪️ Как оптимизировать сканирование сайта для улучшения его индексации в поисковых системах.

- Это поможет узнать, на какие страницы робот заходил, а на какие — нет, какие взял в индекс, а какие — нет.

- Количество публикаций новых материалов ниже, чем выделенная квота со стороны поисковика.

- Получить ссылки с других сайтов непросто, на самом деле это один из самых сложных аспектов в search engine optimization, но это сделает ваш сайт сильнее и улучшит общее web optimization.

- В этом случае, для увеличения краулингового бюджета, рекомендуется уникализировать тексты.

- С помощью встроенного инструмента Netpeak Spider «Валидатор XML Sitemap» вы можете найти критические ошибки (если они имеются) в вашей карте сайта.

Увеличьте Скорость Сайта, Чтобы Ускорить Проверку Страниц Роботами

Анализировать данные следует за период свыше месяца, тогда получится собрать более верную статистику и представлять закономерности, если изменения наблюдаются. Следует избегать большого уровня вложенности страниц, стараться не превышать его более 4-х. Это значит, что пользователь с главной страницы должен добраться до любой другой не более чем за 4 клика. Краулинговый бюджет рассчитывается для каждого сайта отдельно, исходя из его пользовательского спроса и доступности сервера. Поэтому, если отчет не отображает того, что вы сделали со своим сайтом, значит вам нужно искать причину этого.

Итак, чтобы привлечь интерес роботов Google, компания должна соблюдать правила и заботиться о факторах ранжирования, создаваемых поисковой системой. По завершению сканирования директивы, прописанные в виртуальном файле, отобразятся в колонке «Разрешён в robots.txt» в основной таблице. Чтобы этого не произошло, используйте файл robots.txt для устранения динамических бесконечных категорий. Следуйте инструкциям календаря и используйте инструмент URL Parameters Software, предоставляемый Google для форматирования ссылок, чтобы Googlebot мог правильно игнорировать несущественные ссылки. Вы не можете контролировать Googlebot, но вы можете https://deveducation.com/ контролировать то, как он взаимодействует с вашим сайтом. Когда они оптимизированы, вы можете улучшить свой общий бюджет на просмотр и убедиться, что нужные страницы проиндексированы.

Однако каждый компьютер или программа имеет ограниченные ресурсы. Краулинговый бюджет позволяет распределять вычислительную мощность роботов. Чем лучше оптимизация страницы, тем больше она интересует Google. В противном случае он не будет тратить на это время и займется другим сайтом.

Заголовок Last-Modified сообщает браузеру пользователя или роботу ПС информацию о дате и времени последнего изменения текущей страницы. Со временем страницы редиректов уходят из поля зрения поисковиков и индексируются только конечные URL. А представьте, что таких цепочек будет много — пользователю это не заметно, но робот будет вынужден переходить от ссылки к ссылке, чтобы найти нужную страницу. Цепочка редиректов запутает робота и не позволит ему сразу попасть на нужную страницу. Повторимся, речь здесь именно о нескольких страницах с кодом 301, а не об одном редиректе.

Если перенаправление не настроено, то главное зеркало определяется поисковиками автоматически. В таком случае, управление краулинговым бюджетом может усложниться. Проследить за тем, какие страницы посещались краулерами, можно с помощью логов сервера. Логи записываются в специальный файл – access.log, который можно найти в папке logs по протоколу FTP. Краулинг — это индексация, поэтому весь лимит быстро тратится именно из-за ошибок индексации.

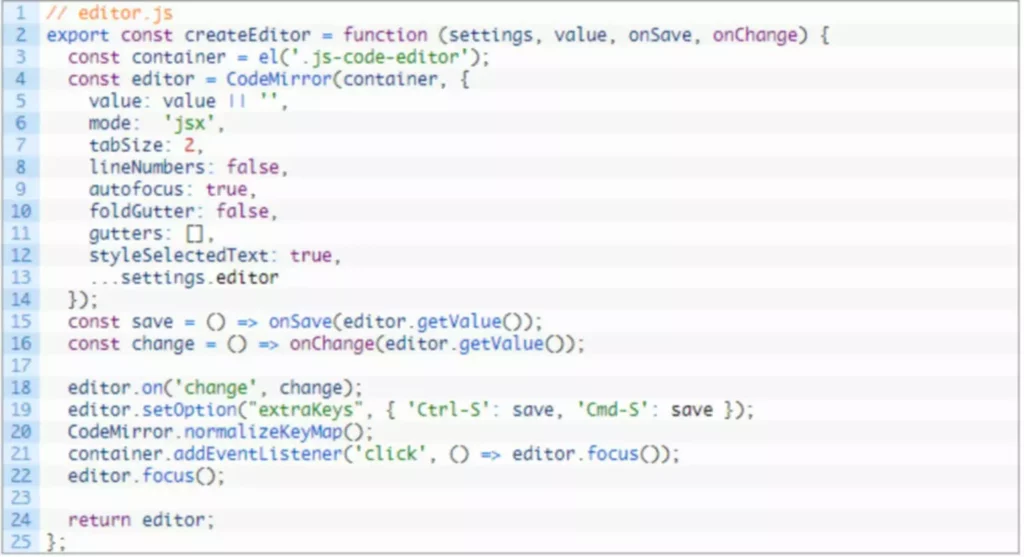

Важно отметить, что если ваш сайт имеет менее URL, доступных для просмотра, вы можете не переживать о краулинговом бюджете. API-интеграции с поисковыми системами реализуются через микросервисы с балансировкой нагрузки для обработки большого количества запросов. Система контроля версий Git используется для управления конфигурациями и автоматического отката изменений при сбоях. Мониторинг метрик осуществляется через связку Prometheus и Grafana с настроенной системой алертинга. Автоматизированные скрипты анализируют логи и метрики производительности, адаптируя настройки краулинга в реальном времени. Оптимизация краулингового бюджета требует последовательного выполнения взаимосвязанных шагов.

Следите за тем, чтобы файл robots.txt не закрывал страницы, важные для продвижения, иначе роботы не будут иметь к ним доступ. Эффективный мониторинг поведения поисковых роботов требует комплексного анализа ключевых параметров и паттернов сканирования. Частота сканирования (crawl rate) отслеживается в динамике с учетом сезонности и типов контента, позволяя оптимизировать распределение бюджета. Анализатор логов выявляет характерные паттерны поведения роботов, включая предпочтительное время сканирования и интервалы между посещениями. Краулинговый бюджет — это комплексный ресурс, который делит поисковая система между миллионами сайтов. Для больших проектов крайне важно оптимизировать техническую инфраструктуру, чтобы максимизировать использование выделенных ресурсов.

Чтобы проверить, настроен ли на отдельной странице заголовок, воспользуйтесь prompt инженер онлайн-сервисом Last-Modified.com. Если на вашем сайте были обнаружены цепочки редиректов, они будут отображены на этой вкладке как ошибка с соответствующим названием. Кликните по ней, чтобы подробно ознакомиться со списком URL на вкладке отфильтрованных результатов. Ввести начальный URL сайта в адресную строку и нажать кнопку «Старт».

Если на сайте не прописаны Last-Modified, сделать это можно в карте сайте через специальные плагины для генерации карты сайта, доступные для большинства популярных CMS, или прописать вручную. К примеру, для сайтов на WordPress есть плагины XML Sitemaps и All in One search engine optimization, для Joomla — JSitemap, а для Drupal — Simple XML sitemap. URL обычно недостаточно, чтобы как-то влиять на краулинговый бюджет.